6.13 Algorithme de recommandation

Temps de lecture de la page : 10 min

→ L’algorithme de recommandation estime une note que l’utilisateur donnerait à un contenu (livre, film, musique, post, etc. ). Grâce à cette note, il recommande le contenu qui :

- a le plus de chance de plaire à l’utilisateur ;

- maximise le profit du vendeur.

Ces algorithmes sont nés dans les années 90 avec l'essor du commerce électronique.

Les personnes en charge du choix et de la conception des algorithmes de recommandation sont principalement les Data scientists. Ils suggèrent des algorithmes à employer en fonction de :

- ceux qu’ils peuvent appliquer d’un point de vue technique ;

- la stratégie du service.

Les algorithmes de recommandation peuvent se baser sur plusieurs types d’éléments tels que :

- recommandation collaborative (un des plus déployés actuellement et un de ceux qui fonctionnent le mieux) :Par exemple, de nombreux utilisateurs ont vu les films « Batman » et « Superman ». Quand un utilisateur regarde « Batman », on lui proposera « Superman ».

- likes : l'algorithme comptabilise le nombre de likes pour déterminer les éléments les plus appréciés. Ces éléments seront mis en avant.

- éléments vus par l’utilisateur : L'algorithme va recommander un élément par rapport à ce que l’utilisateur a déjà regardé. Par exemple, si l’utilisateur a lu Harry Potter 1, on va lui recommander Harry Potter 2.

- images : l'algorithme va utiliser les métadonnées de l’image pour proposer des contenus similaires.

En général, un service exploite plusieurs types d'algorithmes combinés.

Les principaux risques des algorithmes de recommandation sont :

- conformisme de recommandation : se trouver qu’avec des éléments voisins de ceux que l'utilisateur apprécie.

- propagation de biais racistes et sexistes : lorsque l’apprentissage s’effectue sur des données reflétant des stéréotypes.

- mise en avant du bénéfice utilisateur à court terme : lorsque les éléments mis en avant poussent l’utilisateur vers ce qui l’intéresse à l’instant, et non ce qui va le faire progresser. Par exemple, mettre en avant de la nourriture rapide et transformée (hamburger, etc. ) par rapport à de la nourriture saine. En effet, les algorithmes sont pensés pour faire cliquer l’utilisateur.

C’est pourquoi il est important de mettre en place certaines bonnes pratiques comme :

Garder la main sur les algorithmes

Un algorithme est créé par des humains et tout humain a des biais. C’est pourquoi il est essentiel de garder la main sur les algorithmes de recommandation, afin de pallier certains biais présents dans les algorithmes.

Garder la main permet également de mettre en avant des contenus invisibles (qui ne ressortent pas avec les algorithmes utilisés). Par exemple, sur un service de streaming, on peut mettre en avant des films d’auteur, qui sont peu visibles avec les algorithmes, car peu visionnés.

Limiter les systèmes se basant sur le profilage

Le profilage correspond à la création d’un profil opaque et non paramétrable pour chaque utilisateur. En s’en servant, les services travaillent à prédire si un élément devrait plaire ou non à l’utilisateur. Le but est de maximiser le temps passé sur le service ainsi que le nombre d’interactions.

Si on reprend les types d’algorithmes présentés précédemment, on retrouve ce profilage principalement dans les :

- recommandation collaborative ;

- éléments vus par l’utilisateur.

Une partie des contenus lui est invisibilisée, car selon son profil, il serait moins intéressé par ces éléments. Un des principaux risques est d’être enfermé dans un effet de bulle.

Cette pratique est limitée par l’article 38 du DSA. Les très grandes plateformes en ligne sont obligées de proposer au moins un accès au contenu sans profilage.

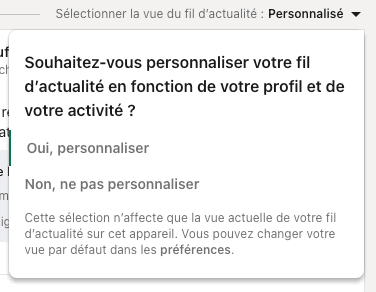

Pour répondre à cette législation, LinkedIn a ainsi ajouté (août 2023) un bouton pour sélectionner le type de vue du fil d’actualité : avec ou sans profilage.

Être transparent

Le choix du type d’algorithme de recommandation correspond à un choix de stratégie. Or, les utilisateurs ne connaissent pas les règles des algorithmes (comment sont choisis les contenus affichés). Ils n’ont aucun contrôle.

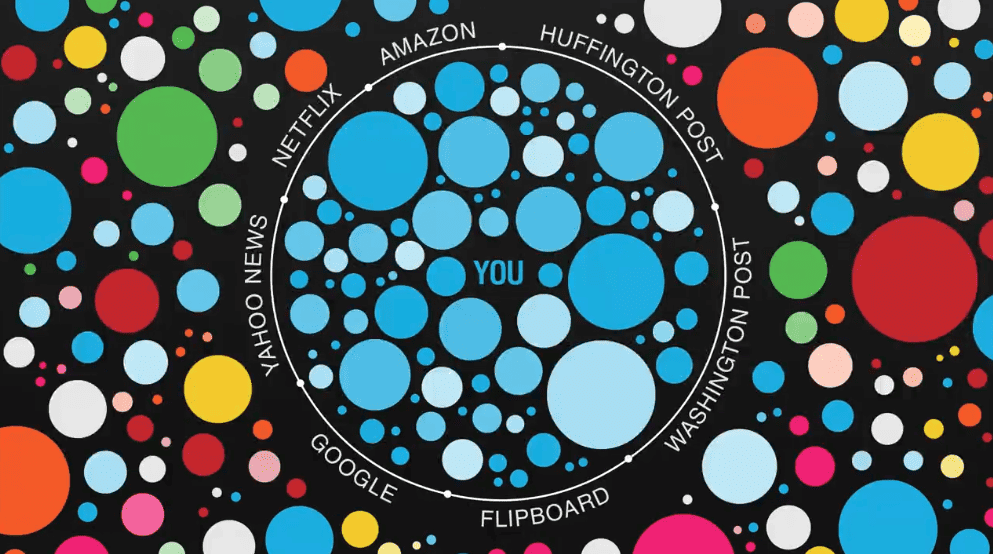

Cette absence de contrôle entraîne un risque d’être enfermé dans des bulles de filtres (principalement visible pour les moteurs de recherche et les réseaux sociaux). Il devient en effet difficile de se forger un avis critique quand on est rarement confronté à des avis opposés.

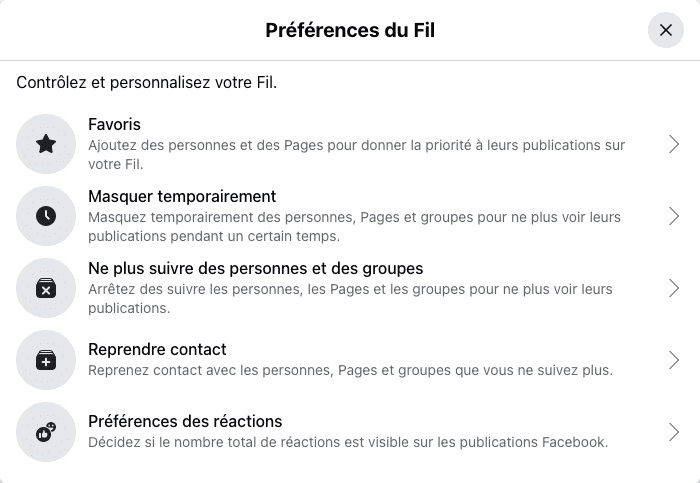

Pour protéger les utilisateurs de ce phénomène, l’article 27 du DSA impose :

- de la transparence sur les principaux paramètres utilisés dans les algorithmes, et pourquoi ;

- des moyens de modifier ou influencer les paramètres de l’algorithme ;

Bonnes pratiques

Pour être transparent, l’utilisateur doit pouvoir :

- comprendre les différents algorithmes utilisés

- contrôler son profil afin de limiter l’effet de bulle.

Faire attention à l'effet de bulle

Avec l’usage des algorithmes de recommandation, l'utilisateur peut se retrouver piégé dans des bulles de filtres.

Ces bulles de filtres existent lorsque l’utilisateur ne voit que des informations paramétrées pour lui, selon ses goûts. Les résultats affichés ne sortent jamais des catégories connues. Cela entretient le biais de confirmation : l'algorithme cache les contenus qui pourraient remettre en question nos croyances. Il est particulièrement dangereux sur des services comme Twitter, où le contenu peut facilement partir dans une extrémisation.

L’effet de bulle est aussi un danger, car l’utilisateur a de grandes chances de ne pas savoir qu’il est enfermé dans une bulle.

Certains sites n'existent plus de manière générique, mais s'adaptent à l’utilisateur. Par exemple, il n’existe plus un Google, mais des Google qui changent selon l’utilisateur (voir la conférence Ted d’Eli Pariser sur les dangers des bulles de filtres).

Source : conférence de d’Eli Pariser sur les dangers des bulles de filtres, mars 2011

Enfin, il faut faire attention à donner aux utilisateurs des solutions pour sortir de leur bulle. L’enfermement que cela peut causer est raconté dans le livre de science-fiction Quality Land de Marc-Uwe Kling.

Dans cet univers, toute personne a un profil utilisateur et ne voit que ce qui a été sélectionné pour lui. On lui choisit son conjoint/conjointe, des produits sont livrés avant même que l’utilisateur ne le demande. Même les actualités présentées sont très différentes d’une personne à l’autre. C’est lorsque le héros du livre a un problème avec son profil et qu’il essaie de le modifier qu’on découvre à quel point cela peut être compliqué de sortir de ces bulles de filtres.

Bonnes pratiques

Si vous travaillez sur un service qui risque d’engendrer des bulles de filtres, il faut :

- être au maximum transparent sur comment fonctionne l'algorithme ;

- permettre à l’utilisateur de paramétrer ce que l’utilisateur voit (voir de remettre ses filtres à zéro) ;

- permettre à l’utilisateur de sortir de sa bulle par moment. Le bouton de Netflix aléatoire aurait pu être une bonne piste, mais il n’est pas totalement aléatoire et reste basé sur les préférences utilisateur.

Pour aller plus loin :

- Fake news and ideological polarization: Filter bubbles and selective exposure on social media (anglais)

- Eli Pariser nous met en garde contre "les bulles de filtres" en ligne - Conférence TED (anglais)

- Livre "The filter Bubble : What the Internet Is Hiding from You" - Eli Pariser (anglais)